简单来说,AI Infra(AI 基础设施)就是为 AI 模型的研发、训练、部署和上线运营提供各种底层支持的整体技术架构和系统。可以把它想象成「让 AI 能跑起来,并且跑得快、跑得稳」的后台支撑。下面分三个部分来解读:职责、定位以及常见技术栈。

(8 封私信 / 7 条消息) 有没有大佬帮我解释一下AI infra到底是干啥的? - 知乎

一、AI Infra 的职责

- 资源管理与分配

- 负责对算力资源(GPU、CPU、存储等)进行高效调度与分配。

- 保证AI任务能在正确的硬件环境里跑起来,且不会因为资源冲突导致训练或推理速度变慢。

- 数据处理和管理

- 负责大规模数据的采集、清洗、格式转换和分发。

- 提供面向模型训练的高吞吐数据管道(Data Pipeline),让模型训练可以持续获得数据输入。

- 训练与开发环境

- 提供统一的环境来支持模型训练、调试和测试(比如容器化、虚拟环境、集群管理等)。

- 提供自动化训练、超参数搜索、模型版本管理等工具(也就是 MLOps/Pipeline)。

- 模型部署和推理服务

- 负责将训练好的模型部署到线上或者提供给其他业务调用的接口,比如 RESTful 或 gRPC 服务。

- 优化推理性能(如批量处理、自动伸缩、缓存机制等)。

- 监控与日志

- 对模型在训练、部署和推理阶段的各项指标进行实时监控,记录错误日志和警报,辅助排查问题。

- 包括模型性能、资源使用情况、延迟、吞吐量等。

- 安全与合规

- 保护数据和模型的安全,比如对敏感数据的脱敏处理,模型版权和访问权限的管控。

- 满足所在行业或地区的合规要求(如GDPR)。

二、AI Infra 的定位

- 与AI研发团队之间的关系

AI Infra 团队可以理解为「内建的技术和平台支持部门」,为上层研发团队(如算法工程师、数据科学家)提供工具、环境,让他们不必再重复造轮子,比如自己搭服务器、搭环境,而是聚焦在模型算法本身。 - 与传统基础设施/DevOps的区别

虽然 AI Infra 跟传统的 DevOps(运维)也有重叠,比如容器化、CI/CD、监控,但 AI 有非常特殊的训练场景(海量数据、GPU 异构计算、大规模分布式训练、模型推理场景等),需要更加专业的技术栈和处理方式。 - 与数据平台/大数据平台的关系

AI Infra 通常跟大数据平台关系紧密,AI 对数据有极高需求(采集、清洗、特征工程、存储),因此很多 AI Infra 的模块会与数据平台融合,或者在数据平台基础上扩展出AI相关的功能。

三、常见技术栈

- 硬件/算力层

- GPU(NVIDIA、AMD等),TPU(谷歌云),或其他加速芯片(如Habana、ASIC等)。

- 高速网络(InfiniBand、RDMA)和大容量存储集群。

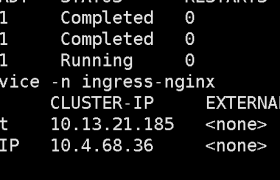

- 容器化与集群管理

- Docker 容器

- Kubernetes(K8s)

- 结合云厂商的容器服务(GKE、EKS、AKS 等)或自建 K8s 集群。

- 分布式训练框架

- 深度学习框架:PyTorch、TensorFlow、JAX 等

- 分布式训练工具:Horovod、DeepSpeed、PyTorch Distributed 等

- 数据处理/分发

- 流式处理:Kafka、Flink

- 批处理:Spark

- 数据存储:HDFS、HBase、Cassandra、Ceph 等

- 特征存储:Feast 等

- 任务编排与流程自动化(MLOps)

- 模型实验管理:MLflow、Weights & Biases、ClearML

- 工作流编排:Kubeflow、Argo Workflows

- CI/CD 管道:Jenkins、GitLab CI、GitHub Actions

- 模型服务化

- 线上推理服务:TensorFlow Serving、TorchServe、Triton Inference Server

- API 网关、负载均衡:Nginx、Envoy 等

- 服务治理:Istio(Service Mesh)

- 监控与可视化

- 资源监控:Prometheus + Grafana

- 日志与可观测:ELK (Elasticsearch + Logstash + Kibana) 或者 Loki + Grafana

- 模型可视化:TensorBoard、MLflow UI 等

- 安全与权限管理

- 数据加密、访问控制

- 身份认证和权限体系(IAM)

- 隐私保护和合规(GDPR等)

总结

- AI Infra 可以理解为一套帮助 AI 模型从「研发到上线」的全流程支撑体系。

- 它的职责是给算法和模型提供底层技术保障,包括环境搭建、数据管理、训练支持、部署推理、监控运维和安全等。

- 技术栈多样,需要从硬件到软件、从训练到上线都进行打通,往往要结合大数据、云计算、DevOps/MLOps 等技术。

所以,如果你看到「AI Infra」,就可以想到:这是一支专门搞「AI 跑起来并跑得稳、跑得快」的团队或系统,把各路大神的算法模型成功应用到实际生产环境中去。

欢迎来撩 : 汇总all