大模型 汇总 : 连接

在 Linux 系统上安装千问(Qwen)和 DeepSeek,最主流且简单的方式是使用 Ollama。它是一个专为本地运行大模型设计的工具,支持一键拉取和运行模型,无需复杂的环境配置。

Ollama 是目前体验大模型最便捷的方式,支持 NVIDIA GPU(CUDA)和 Apple Silicon(Metal)加速。

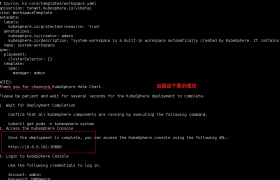

1. 安装 Ollama

打开终端,执行以下命令:

curl -fsSL https://ollama.com/install.sh | sh安装完成后,启动 Ollama 服务:

systemctl --user start ollama首次运行会自动下载模型文件(约 4-5GB),请耐心等待下载完成。

安装 通义千问 (Qwen):

推荐安装最新的 Qwen2.5 系列,例如 7B 版本:

ollama run qwen2.5:7b-instruct3. 使用方式

模型下载并加载成功后,终端会出现 >>> 提示符,直接输入你的问题即可开始对话。

欢迎来撩 : 汇总all