在华为昇腾服务器Ascend 300I Pro 310P芯片( 310P3)安装QWQ32B大模型以及deepseek蒸馏版!-CSDN博客

上边的是收费的,

下边的是 免费版

在华为昇腾服务器Ascend 300I Pro 310P芯片( 310P3)安装QWQ32B大模型以及deepseek蒸馏版!-EW帮帮网

在华为昇腾服务器Ascend 300I Pro 310P芯片( 310P3)安装QWQ32B大模型以及deepseek蒸馏版! - 网硕互联帮助中心

这两个对比这来吧。

鲲鹏+昇腾(310P)部署Qwen3-32B【简单版】_昇腾300i duo部署qwen3-CSDN博客

根据

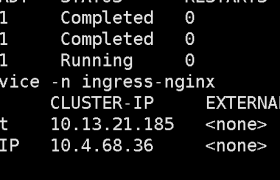

npu-smi info 的输出,你的昇腾(Ascend)NPU 环境已经准备就绪,可以开始部署 DeepSeek 模型了。以下是详细的环境分析和接下来的部署建议:

1. 环境状态分析

- NPU 型号:

310P3。- 这是一个比较新的边缘推理卡型号(算力约为 16/20 TFLOPS INT8)。

- 注意:310P3 显存较小(约 16GB 或 32GB,具体看版本,但从截图看是 44GB 规格,可能是 310P3 的大显存版本或者多卡聚合,需要确认单卡显存)。DeepSeek-V2/V3 如果是全精度(FP16)可能放不下,必须使用量化版(INT4/INT8)。

2. 部署 DeepSeek 的具体建议

鉴于你使用的是

310P3,它不支持像 910B 那样多实例切分,通常是一卡跑一个模型实例。第一步:确认软件栈 (CANN)

在运行之前,请确保你已经安装了配套的 CANN 软件包。

在终端执行:

在运行之前,请确保你已经安装了配套的 CANN 软件包。

在终端执行:

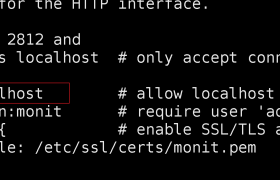

# 检查 CANN 版本,建议 8.0.RC1 或更高版本

npu-smi info | grep "Driver version"

# 或者检查环境

echo $ ASCEND_HOME第二步:选择推理框架

对于 DeepSeek 在 310P3 上的部署,推荐两种方案:

方案 A:使用 MindIE (MindSpore Inference Engine)

这是华为官方推荐的大模型推理方案,优化最好。

这是华为官方推荐的大模型推理方案,优化最好。

- 模型获取:去 ModelScope 下载

DeepSeek-V3-xxx-Ascend或DeepSeek-MoE-xxx-Ascend的 W8A8(8比特量化)版本。 - 配置修改:在模型配置文件中,确保

use.flash.attn=False(310P3 不支持 flash_attn,必须关闭)。 - 启动:使用

msrun命令启动推理服务

Qwen2.5-72B-Instruct-w8a8-vllm-ascend · 模型库

modelscope download --model RR2025/Qwen2.5-72B-Instruct-w8a8-vllm-ascend README.md --local_dir ./dir

方案 B:使用 vLLM-Ascend

如果你习惯用 vLLM 的接口。

如果你习惯用 vLLM 的接口。

- 安装

vllm-ascend包。 - 使用如下命令启动(示例):

python -m vllm.entrypoints.openai.api_server \

--model /path/to/deepseek-quantized \

--dtype int8 \ # 强制使用 int8

--tensor-parallel-size 1 # 310P3 通常单卡运行

欢迎来撩 : 汇总all